Betrug beim Verfassen von Doktorarbeiten kommt gar nicht so selten vor. Das ist kein neues Phänomen. Schon dem Historiker Friedrich Wilhelm Prinz von Preußen wurde 1973 der Doktortitel wegen Plagiierens aberkannt. Damals war es noch relativ einfach gewesen, nachzuweisen, dass jemand abgekupfert hatte. Im Zeitalter künstlicher Intelligenz verkompliziert sich die Sache für Prüfer deutlich.

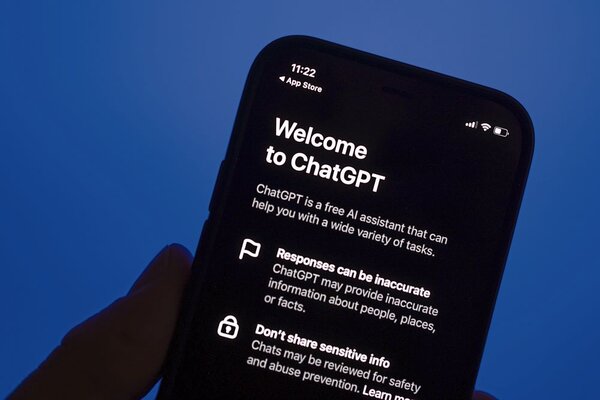

Kaum ein Student verzichtet heutzutage auf KI. Das weiß auch das Centrum für Hochschulentwicklung (CHE). „Aktuelle Studien zeigen, dass knapp 92 Prozent der Studierenden KI nutzen“, erklärt Jannica Budde vom CHE-Hochschulforum Digitalisierung. Fragt man Dozentinnen und Dozenten von bayerischen Universitäten, heißt es allerdings noch vielerorts, dass die von Studentinnen und Studenten angefertigten Arbeiten weiterhin zum allergrößten Teil wohl auf eigenständiger Denkleistung beruhen. So sei er bei Durchsichten bisher noch nicht auf KI gestoßen, erklärt Josef Franz Lindner von der Uni Augsburg.

Der Rechtsphilosoph weiß allerdings, dass er damit künftig rechnen muss. Der Einsatz von KI beim Abfassen von Haus-, Bachelor-, Master-, Promotions- und Habilitationsarbeiten ist schwer nachweisbar. Schrieb jemand bisher auf Wikipedia oder anderswo ab, konnte der Prüfer nach den entsprechenden, verdächtigen Passagen im Netz suchen. Wurde er fündig, war der Beweis erbracht: Da hat jemand einfach abgeschrieben. KI allerdings spuckt, je nach Prompts, also Stichworten, individuelle Texte aus. „Man würde den Einsatz von KI weder am Stil noch am Inhalt noch in der Darstellungsweise merken“, sagt Josef Franz Lindner.

Auch Dietmar Süß, Inhaber des Lehrstuhls für Neuere und Neueste Geschichte an der Universität Augsburg, kam bisher noch keine Doktorarbeit unter, bei der er den Verdacht gehabt habe, dass sie mithilfe von künstlicher Intelligenz entstand. Selbst bei Master- und Examensarbeiten scheint ihm dies noch nicht im großen Stil verbreitet zu sein: „Das mag sich aber bald ändern.“ Kommt ihm der Verdacht, überprüft er die entsprechenden Textstellen und Literaturangaben sehr genau. „Die KI-Tools arbeiten in der Regel noch fehleranfällig“, so seine Erfahrung. Sie erfänden zum Beispiel Seiten. Oder Quellen.

KI wird die Geschichtswissenschaft verändern

Noch wird dem Historiker zufolge recht schnell offensichtlich, ob Verfasser wissenschaftlicher Arbeiten die Texte, auf die sie sich berufen, tatsächlich in der Hand hatten. Aber auch das werde sich vermutlich bald ändern. Aufgaben müssten deshalb künftig anders gestellt werden. Und zwar so, dass die Studenten gezwungen sind, eigenständige Lösungen zu entwickeln.

Dietmar Süß baut den Umgang mit KI inzwischen in seine Lehre ein. Künstliche Intelligenz, sagt er, werde die Arbeit in der Neuesten Geschichte stark verändern. Textrecherchen würden einfacher. Dank KI können künftig große Quellensammlungen rasch ausgewertet werden. Künstliche Intelligenz wird wahrscheinlich auch schwierige Handschriften lesbar machen. Doch es gibt eine Kehrseite der Medaille. Für Süß stellt sich die Frage, wie authentisch und von welchem Wert KI-generierte Quellen sind. Studenten zu befähigen, kritisch mit Quellen umzugehen, werde darum immer wichtiger.

Andreas Renner vom Lehrstuhl für Russland-Asien-Studien an der Universität München hatte unlängst bei einer Zulassungsarbeit den Verdacht, dass KI zum Einsatz gekommen war. Auch nach seiner Auffassung gibt es eindeutige Kriterien, die hierauf verweisen. Denn auch, wenn den Algorithmen „Intelligenz“ unterstellt wird, sind sie, zumindest Stand heute, im Vergleich zum Menschen ziemlich geistesarm. „Die Infos sind oft oberflächlich, widersprüchlich und nicht richtig in die Argumentation eingebaut“, sagt er. KI stellt für den Historiker deshalb noch keine Konkurrenz dar. Quellen zu analysieren, sie zu interpretieren und in einen Kontext stellen, könne bisher allein der Mensch wirklich gut.

Manfred Pirner vom Lehrstuhl für Religionspädagogik an der Uni Erlangen-Nürnberg kam bei Seminararbeiten schon manchmal die Vermutung, dass künstliche Intelligenz mitgemischt hat. Erhärtet sich der Verdacht, testet er bei einem Gespräch, inwiefern der Student mit den Inhalten vor allem von anspruchsvollen Passagen seiner Arbeit vertraut ist. In die Lehre hat KI bei ihm längst Einzug gehalten, berichtet der Religionspädagoge. Seine Studentinnen und Studenten lernen zum Beispiel religiöse Avatare kennen. Außerdem gebe es zahlreiche KI-generierte Jesus-Storys auf TikTok.

Jens Tobor vom Hochschulforum Digitalisierung am Centrum für Hochschulentwicklung weist darauf hin, dass KI-Tools noch keine kompletten Abschlussarbeiten auf Knopfdruck erzeugen. Was die Werkzeuge können, ist auch nach seiner Ansicht bisher alles andere als brillant. KI reproduziere Stereotype. Sie argumentiere politisch nicht neutral. Nicht selten seien die Zitate falsch.

Nach seiner Auffassung müssen Hochschulen stärker an die Verantwortung von Prüflingen appellieren. In den meisten Lehrveranstaltungen werde akademische Integrität vorausgesetzt, erklärt er. Das sei in Zeiten von KI nicht mehr möglich. Durch Eigenständigkeitserklärungen könnten Studentinnen und Studenten rechtswirksam versichern, dass sie die Regeln zum KI-Einsatz beachtet hätten.

Jannica Budde und Jens Tobor plädieren schließlich dafür, sich Zwischenstände von Arbeiten in Kolloquien vorstellen zu lassen und am Ende mündlich zu prüfen. Dann werde klar, ob jemand das Thema seiner Arbeit tatsächlich durchdrungen hat. Dies sei natürlich mit Aufwand verbunden.

Auch Thomas Volling, Vorstandsmitglied im Verband der Hochschullehrerinnen und Hochschullehrer für Betriebswirtschaft, rät Betreuern von Promotionen, regelmäßig mit den Promovenden über die Forschungsarbeit zu diskutieren. „Im Forschungsprozess nimmt der Stellenwert einer guten und lückenlosen Dokumentation von Quellen, Vorgehen und Daten nochmals zu“, sagt er. Eine mündliche Verteidigung nach Abgabe der Promotion hält er ebenfalls für sinnvoll.

„Klar sollte sein, dass akademische Abschlüsse im Fall von Täuschungen oder eines Plagiats auch noch nach Jahren aberkannt werden können“, sagt der Wirtschaftswissenschaftler. Zwar sei es derzeit noch nicht immer möglich, KI-generierten Output verlässlich zu erkennen. Künftig werde dies jedoch wahrscheinlich der Fall sein: „Das macht den missbräuchlichen Einsatz von KI aus meiner persönlichen Sicht sehr risikoreich.“ (Pat Christ)

Kommentare (0)

Es sind noch keine Kommentare vorhanden!